Warum wird deine Webseite eigentlich aufgerufen? Welche Inhalte interessieren die Besucher:innen? Welche Marketingstrategie solltest du einsetzen? Auf welche Wörter und welches Design reagiert welche Zielgruppe?

Die Antworten dieser Fragen ist die Grundlage für datenbasierte und fundierte Entscheidungen, um die Verbesserung von gewinnbringenden Komponenten deines Stores (Nutzerfreundlichkeit, optimiertes Design, optimales Kauferlebnis) zu optimieren.

Um genau herauszufinden, was welche Zielgruppe bevorzugt, musst du unterschiedliche Inhalte, Designs und Kommunikationsstile anwenden. Doch dieser Prozess kann unter Umständen zeit- und ressourcenintensiv sein. Daher benötigst du eine Methode, um die beste gewinnbringende Konstellation für Inhalt und Design zu identifizieren, ohne viel Geld und Zeit zu verlieren. Hier kommt der sogenannte A/B-Test ins Spiel.

In diesem Artikel wirst du mehr über A/B-Test Methoden erfahren. Wie funktionieren solche Tests? Warum ist es für Umsatzsteigerung wichtig? Und wie kannst du sie planen und einsetzen?

Inhaltsverzeichnis:

|

Warum A/B-Testing?

Nehmen wir an, du gibst 1000 € für Werbung aus, um 100 Leads / Besucher:innen auf deine Webseite aufmerksam zu machen. Im Durchschnitt geben sie 100 € für eine Bestellung aus. Mit einer Kaufrate von 4-6% kaufen die Kunden für 400-600 € bei dir ein. Das bedeutet, du hast sogar Verlust gemacht.

Nun das gleiche Beispiel mit einer höheren Verkaufsrate von 12%, Bestellwert von mindestens 100 €, dann hast du 200 € Gewinn erzielt.

A/B-Test hilft dir:

-

Ressourcen (Geld, Zeit, Arbeit) zu optimieren

-

Schwachstellen zu identifizieren

-

Verbesserungspotenzial zu erkennen

-

Bessere Planung mit datenbasierter Einschätzungen zu ermöglichen.

Was sind die A/B-Tests?

Wie bereits in der Einleitung kurz erwähnt, ist der A/B-Test oder Split-Test eine Testmethode, die zwei Versionen (z.B. von einer Webseite oder einem Newsletter) miteinender vergleicht, um festzustellen, welche Version bei Interessent:innen besser abschneidet.

Dieser Prozess ermöglicht, datengestützte Entscheidungen zu treffen und Wissensgrundlage zu sein, um mehr Umsatz aus dem bereits vorhandenen Traffic zu generieren.

Für A/B-Testing gibt es in der Regel zwei Hauptelemente:

-

Kontrolle: das ist die erste Webseite, die du entworfen hast

-

Variation: das alternative Design, das du verglichen mit dem ersten Entwurf testen möchtest

Wie funktioniert A/B-Testing und A/B/n-Testing?

A/B-Testing

Webseiten:

Im Marketing Kontext werden beispielsweise zwei Versionen von einer Webseite erstellt. 50% der Besucher:innen sehen Version A (Kontrolle) und die andere 50% werden Version B (Variante) sehen.

Am Ende werden die Daten miteinander verglichen und die Version mit der höchsten Conversion Rate als “Standard” festgelegt. Die “Sieger”-Version wird jetzt die neue Kontroll-Version bzw. Standard.

Für einen neuen Test erstellst du eine weitere Version der Webseite als Variante, um die statistische Analyse neu durchzuführen. Diese Methode kann verwendet werden, um Registrierung, Klicks, Käufe, usw. zu messen.

Apps:

Statt zwei Versionen von der gleichen App zu entwerfen, wird das Design der App in 50% der Fälle abgeändert, um zu messen, was diese Änderungen bewirkt haben.

Quelle:https://www.vecteezy.com/

A/B/n-Testing

Anders als beim A/B-Testing, lassen sich bei A/B/n-Tests mehr als eine Variante gegenüber der Kontroll-Variante testen.

Anstatt also 50% der Besucher:innen die Kontrolle und 50% der Besucher:innen die Variante zu zeigen, kannst du 25% die Kontrolle, weitere 25% die erste Variante, 25% die zweite Variante und nochmals 25% die dritte Variante zeigen.

Es ist erwähnenswert, dass dieser Test sich von multivariaten Tests unterscheidet, die ebenfalls unterschiedliche Varianten beinhalten. Bei multivariaten Tests werden neben den verschiedenen Varianten noch weitere Aspekte wie UX Design, SEO usw. geprüft, mit dem Ziel, die beste Kombination zu identifizieren.

A/B-Test allein reicht nicht aus

Um aufgestellte Hypothesen zu testen, werden neben dem A/B-Test weitere Informationsquellen und Methoden benötigt.

Beispiele für diese Informationsquellen sind:

- Web Analytics Daten: bieten Daten über Nutzeraktivitäten für die ganze Webseite, einzelnen Seiten oder bestimmte Elemente auf einer Webseite. Diese sind keine detaillierte Übersicht über Nutzerverhalten, jedoch kann dies für die Priorisierung und Vorqualifizierung der Kontrolle und Variante vor einem Test helfen.

- Heatmaps und Session Recording: Methoden, die Interaktion der Nutzer:innen auf der Seite als ganzes und für Teilelemente zeigen wie Buttons, Bilder, Menüs usw.

- Kundenanliegen und Fragen

- Produkt Review

- Anrufe, Live-Chat, E-Mails

- Reklamationen und Vorschläge

- Umfragen

Was wird getestet?

Bevor du einen Test startest, musst du genau festlegen, was genau getestet wird. Das klingt selbstverständlich, jedoch führen Unklarheiten öfter zu ungenauen Testergebnissen. Der Test ist ein Werkzeug, das helfen soll ein Problem zu lösen. Daher muss dieses Problem zuerst erkannt und so genau wie möglich beschrieben werden.

Die Herausforderung hier liegt daran, dass viele Variablen beteiligt sind. Laut Statistiken können bekannte Probleme wie Warenkorbabbrüche eine Reihe technischer, inhaltliche oder auch Design-bezogene Gründe haben. Um die Komplexität der Situation zu konkretisieren, werden eine oder mehrere Hypothesen aufgestellt und getestet. Die Analyse der Testdaten sollten diese Behauptungen bestätigen oder widerlegen.

Die Hypothese soll folgende Aspekte umfassen:

-

Was sind die Ursachen des Problems?

-

Was ist eine mögliche Lösung?

-

Was sind die erwarteten Ergebnisse?

Beispiele für A/B-Test Hypothesen:

-

“Eine Änderung von ---------------- auf ----------------- soll ---------------- erhöhen/verringern”

-

“Die Anpassung des Call to Action von “Jetzt kaufen” auf “Nur heute verfügbar” kann den Umsatz verbessern.”

-

“Die Vereinfachung des Anmeldeformulars soll die Zahl der Anmeldungen erhöhen.”

Um die Genauigkeit des Ergebnisses zu erhöhen, empfiehlt es sich einzelne Elemente unter die Lupe zu nehmen.

Online-Stores bestehen aus vielen Elementen, allerdings nennen wir die Hauptelemente mit Bezug auf die Conversion Rate:

Die Hauptseite

- Ist der Titel der Seite und des Produkts klar und selbsterklärend?

- Kann der Titel die Neugier der Nutzer:innen wecken?

- Ist der CTA (Call to Action) richtig platziert und interessant designt?

- Sind die Menüs leicht zu bedienen und zu navigieren?

- Verlängert die aktuelle Zusammenstellung von Bildern und Texten die Navigationszeit?

Produktseite

- Wie schnell können Produkte gefiltert und gefunden werden?

- Wo werden “mehr Umsatz bringende Produkte” platziert?

- Führt die Nutzung der Icon-Sprache in der Produktbeschreibung zu mehr Kaufbereitschaft (Kauf abschließen oder in der Wunschliste speichern)?

- Welche Strategie von Produktempfehlungen kann den Warenkorbwert steigern?

- Kann ein Schnell Check-out Button auf der Produktseite die Klickrate erhöhen?

- Da die meisten Kund:innen nur eine Transaktion durchführen, kann ein “zum Warenkorb hinzufügen & bezahlen” Button die Kaufrate erhöhen

Warenkorb

- Können Gütesiegel für sichere Zahlung und Logos für Zahlungsmittel das Vertrauen an der Webseite verstärken?

- Kann ein sichtbarer Button mit “jetzt bezahlen” die Kunden ermutigen zu klicken?

- Kann eine Bestellung ohne Registrierungspflicht die Warenkorbabbrüche verringern?

- Kann eine visuelle Darstellung für Check-out und Zahlsuchprozesse für mehr Kaufabschlüsse sorgen? Zum Beispiel 1. Dateneingaben 2. Bezahlen 3. Bestätigen, sodass Kund:innen wissen, was auf sie zukommt und wie viele Schritte noch bis zum Kaufabschluss bleiben.

Formulare

- Kann weniger Datenabfrage für mehr Anmeldungen sorgen?

- Soll das Anmeldeformular zum Konto oder Newsletter am Ende der Webseite oder in der Mitte platziert werden?

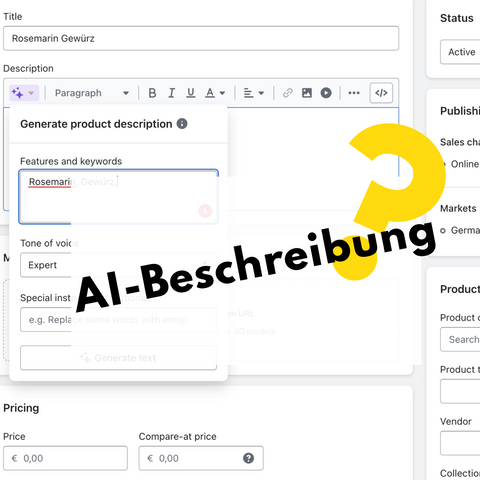

Welche Elemente werden getestet?

Im letzten Abschnitt wurden Beispiele für Funktionalitäten und Prozesse, die getestet werden können, vorgestellt. Diese Funktionalitäten und Prozesse bestehen wiederum aus einzelnen Elementen, die den Unterschied machen, ob z.B. ein Button geklickt wird oder nicht. Diese Elemente sind:

Texte:

- Überschriften, Unterschriften, Typografie, visuelle Hierarchie

- eindeutige Bezeichnung, Klarheit der Wortwahl und Sprache, Länge der Sätze, Schreibstil, Formulierungen

- Tonalität und Informativität

- Metadaten

Design:

- Reihenfolge, Größe, Zahl und Position der Elemente

- Bilder: Anzahl, Position, Größe, Hintergründe, Qualität

- Buttons: Farbe, Größe, CTA, Position, Form

- Gesamterscheinung: Visuelle Hierarchie und Farbschema

Nutzerfreundlichkeit:

- Auffindbarkeit der Information, Filter, Suchfunktion, Hervorhebung von wichtigen Informationen

- Seitenstruktur, intuitive Navigation, Anzahl der Menüs und Klicks bis zur Bestellung

- Bestellprozess und Schritte

- Anmeldung und Registrierungsprozess

- Personalisierte Produktempfehlungen

Jetzt testen

Wie oft solltest du testen?

Für bessere Ergebnisse solltest du mindestens ein Mal testen, zwei Mal wäre noch besser. Du solltest auch keinen Test abbrechen, da dieser die letzten Resultate bestätigt oder doch neue Erkenntnisse ergibt.

Welche Test-Tools gibt es?

Es gibt verschiedene Einsatzmodelle, wie der A/B-Test durchgeführt wird, je nach Lösung und Tool. Für manche Tests, bei denen eine Änderung des Quellencodes erforderlich ist, sind fachliche Kenntnisse nötig. Wobei die anderen anhand der grafischen Oberfläche einer Software durchführbar sind.

Beispiele für Test Tools:

-

Google Optimize. Kostenlos, mit Ausnahme einiger multivariater Einschränkungen, die dich aber nicht wirklich einschränken sollten, wenn du gerade erst anfängst. Es funktioniert gut, wenn du mit Google Analytics A/B-Tests durchführst.

-

VWO. VWO hat SmartStats, um die Analyse zu erleichtern. Außerdem verfügt es über einen großartigen WYSIWYG-Editor für Anfänger. Jeder VWO-Plan enthält Heatmaps, On-Site-Umfragen, Formularanalysen usw.

-

Optimizely. Kleinere Tests lassen sich auch ohne technische Kenntnisse leicht einrichten und durchführen. Stats Engine erleichtert die Analyse der Testergebnisse. In der Regel ist Optimizely die teuerste der drei Optionen.

Die Einstellung des Tests wird entweder von Storebetreiber:innen selbst oder von externen Dienstleister:innen vorgenommen, die das Design der Varianten mitgestalten und jeweils gegenüber der Kontroll-Version testen.

Welcher Test für welches Szenario?

Für jede Webseite kann ein anderer Test eingesetzt werden, das hängt von einigen Faktoren ab wie:

Klassischer A/B-Testing:

A/B-Testing ist eine Testmethode, bei der eine Kontrollversion mit einer Vielzahl kleiner, einzelner Änderungen mit dieser Kontrollversion verglichen wird, um festzustellen, welche Version am besten abschneidet.

Quelle: smashingmagazine.com

Split Test:

Split-Testing und A/B-Testing sind Begriffe, die häufig synonym verwendet werden. Split-Testing ist jedoch eine Testmethode, bei der eine Kontrollversion deiner Website mit einer völlig anderen Version verglichen wird, um herauszufinden, auf welche Version die Website-Besucher:innen am besten reagieren.

Multivariater Test (MVT):

ist eine Form des Experimentierens, bei der mehrere Elemente einer Webseite verändert und getestet werden, um festzustellen, welche Kombination der Seite zu den größten positiven Auswirkungen auf die Conversion führt. So wie beim A/B-Test der Traffic auf die beiden Varianten aufgeteilt wird, wird er beim multivariaten Test auf alle Varianten aufgeteilt. Multivariate Tests sind besonders nützlich, wenn du die Auswirkungen von umfassenden Änderungen auf einer Webseite testen möchtest, anstatt nur die Auswirkungen eines bestimmten Elements zu testen.

Dokumentieren

Die Testergebnisse musst du (oder die Agentur) unbedingt dokumentieren und archivieren. Der Testbericht soll folgende Informationen umfassen:-

Testname

-

Testzeitraum

-

Welche Hypothese wurde getestet

-

Was sind die Varianten und die Kontrolle. Beschreibung und Screenshots.

-

Die Ergebnisse vorstellen

-

Erwartungen und Einschätzungen (z.B. 5% mehr Umsatz für 12 Monate)

Beste Version

Jetzt liegen die dokumentierten Ergebnisse mit einer klaren Empfehlung für die beste Version mit besserem Potenzial vor. Diese Version soll jetzt als die Hauptvariante festgelegt werden, bis zum nächsten Test mit aktualisierten Angaben. Anschließend muss auch geprüft werden, ob die beste Version den Einschätzungen langfristig gerecht wird.

Die Auswertung

A/B-Testing Tools verfügen über Dashboards, die die Conversion pro Variante und die prozentuale Verbesserung messen. Außerdem werden weitere Daten wie Traffic-Quelle, Geodaten, Kundentype, usw. erfasst und visualisiert. Die Herausforderung der Auswertung besteht darin, eine ausreichende statistische Zuverlässigkeit zu erlangen.

Am besten führst du zuerst einen A/A Test durch, um das Zufallsprinzip der Besucherverteilung auf verschiedenen Versionen zu testen. Eine Entscheidung bei der Auswertung soll erst nach dem Erreichen von 95% Zuverlässigkeitsrate getroffen werden.

Es empfiehlt sich auch, nur eine Variable zu testen. Ansonsten wäre es schwierig zu determinieren, welches Element die Änderung verursacht hat.

Anwendungsszenarien

Bis jetzt wurde über Webseiten als Testobjekt gesprochen, allerdings können die A/B Varianten in verschiedenen Anwendungen sehr hilfreich sein, beispielsweise:-

Verschiedene Landingpages für ein Produkt gegenseitig testen

-

Akzeptanz und Nutzung von Features oder Funktionen messen

-

Einzelne Elemente auf der Webseite optimieren (Buttons, Banner, Bilder, Menüs, usw.)

-

Newsletter: Um die Interaktionen mit unterschiedlichen Inhalten, und Designs zu bewerten

-

SEO Maßnahmen testen

-

Ladezeit und Geschwindigkeit

-

Optimierung für Mobilgeräte

Test Beispiele

Zuerst muss dir klar sein, dass es keine allgemeine Empfehlung gibt, was du testen solltest und was nicht. Einige sprechen eine langfristige A/B-Testung als Empfehlung aus. Das solltest du vermeiden. Zu viel testen ohne Vorwissen oder Bedarf ist nicht unbedingt effektiv.

Hier ist der Tipp

“Die besten Tests, die du führen kannst, sind die Tests, die auf eigenen Daten basieren”. Mit anderen Worten: mit einem Zugang zu den Daten lässt sich determinieren, welchen Test dein Store benötigt. Aber welche Tests gibt es denn eigentlich? Einige beliebte Beispiele für A/B-Tests sind:

Technische Analyse:

Hier wird geprüft, ob die Inhalte für alle Browser und auf allen Geräten Desktop/Mobile, usw. schnell laden. Dadurch kannst du einige Hauptgründen für eine schwache Conversion Rate aufgrund nicht optimierten Designs herausfinden.

Umfragen:

Gespräche mit Kund:innen:

Das kann ein langer Chat oder langes Telefonat sein. Sowohl für Stammkund:innen als auch für Neukund:innen kannst du solche Gespräche vereinbaren, um beispielsweise herauszufinden:-

Wie sie den Store gefunden haben?

-

Was am meisten an dem Store gefällt (z.B. Service, Design)?

-

Ob sie den Store weiterempfohlen haben?

-

Welche Funktionalitäten oder Angebote wünschen sie sich?

-

Und viele andere Fragen…

Datenanalyse mit Analysetools:

Wie bereits erwähnt, diese Tools geben dir eine Übersicht:

-

Woher die Besucher:innen kommen

-

Wie lange bleiben sie auf der Seite

-

Wo brechen sie ihren Besuch ab

-

Was sind die beliebtesten Seiten im Store

-

usw.

*** Wenn deine Analyse Tools richtig eingestellt sind, sind die Berichte über Nutzerverhalten eine zuverlässige Datenquelle für detaillierte Diagnose deines Onlinestores.

Das solltest du beachten

-

Immer Kontrolle und Variante gleichzeitig testen. Erst testen, wenn beide Versionen bereit sind, ansonsten hast du ungenaue Ergebnisse.

-

Die Ergebnisse nicht zu früh interpretieren, bist du eine "statistische Zuverlässigkeit" von 95% erreicht hast. Ein paar Klicks oder Conversions bedeuten zunächst nicht viel, ohne dass das Gesamtbild berücksichtigt wird.

-

Neue und Stammkund:innen mit einbeziehen. Überraschende große Änderung der Webseite ohne Vorwarnung oder Hinweise kann Besucher:innen verwirren.

-

Testergebnisse nicht emotional interpretieren. Es ist nicht selten, dass die Resultate nicht intuitiv sind und die “Gewinner” Version oft nicht das, was zum Beginn vermutet wurde. Aus diesem Grund solltest du auch keinen Test frühzeitig beenden.

-

Wiederkehrende Besucher:innen sollten die gleichen Variationen sehen. Dein Tool sollte über einen Mechanismus verfügen, der sich merkt, welche Variante Besuchende bereits gesehen haben. Dadurch werden Fehler vermieden, z. B. wenn Nutzer:innen einen anderen Preis oder ein anderes Angebot angezeigt wird.

-

Der Test sollte auf der gesamten Webseite einheitlich durchgeführt werden. Wenn du eine Anmeldeschaltfläche testest, die an mehreren Stellen erscheint, sollten Besucher:innen überall die gleiche Variante sehen. Wird eine Variante auf Seite 1 und eine andere auf Seite 2 angezeigt, werden die Ergebnisse beeinträchtigt.

-

Mehrfach testen ist immer besser. Ein A/B-Test kann nur drei Ergebnisse haben: kein Ergebnis, ein negatives Ergebnis oder ein positives Ergebnis. Der Schlüssel zur CRO (Conversion Rate Optimierung) liegt in der Durchführung zahlreicher A/B-Tests, um die Ergebnisse zu validieren und zuverlässige Daten für fundierte Entscheidungen zu liefern.